DAS 数据分析

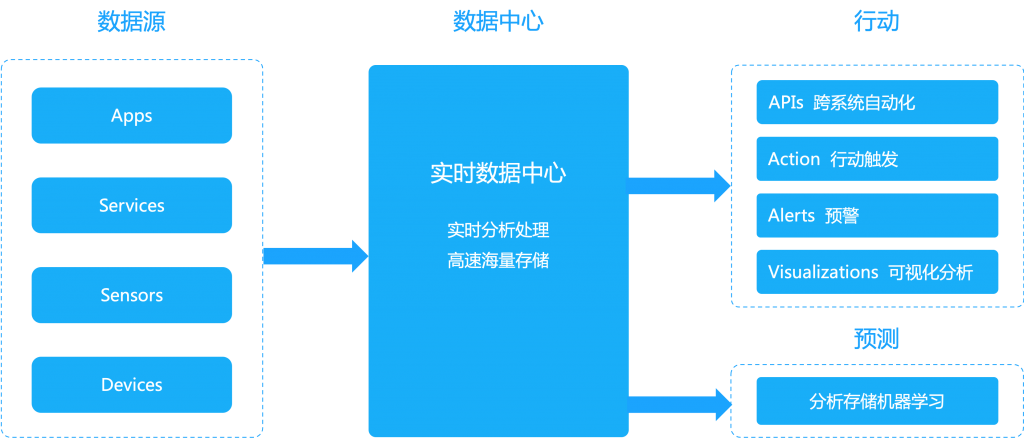

监听不同来源的事件流,并实时处理。此外将实时分析与批处理、数据分析结合到一个集成平台中,支持物联网(IoT)解决方案的多种需求。

事件处理集成

T+N 延时数据处理「事后分析」,已经无法响应当前的信息处理要求;

T+0 实时服务「事中及时响应」,使得数据赋能得以真正落地。

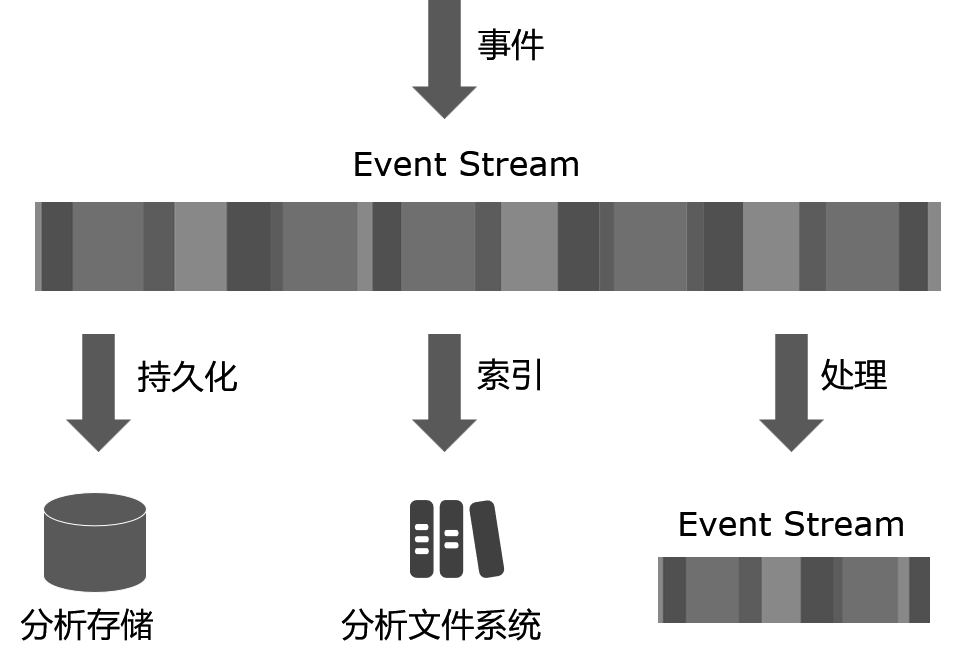

实时获取事件数据

为外部数据源公开了一个 API,以向其发布数据事件。此外,提供可配置的选项来处理数据事件流流入(在内存中)以进行实时分析、持久化(在数据存储中)以进行批处理分析和交互式分析建立索引。

● 创建事件流

● 持久化事件

● 创建事件接收器

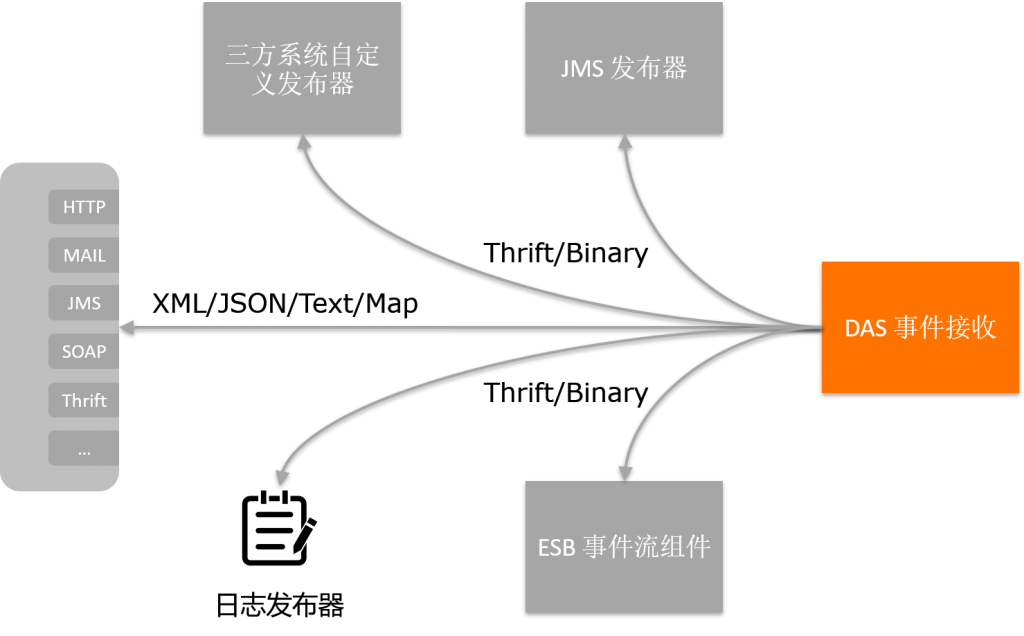

发布数据到DAS

● 通过 Thrift 或 Binary 使用 Java 客户端发布数据

● 用数据代理从各种数据收集点(例如 ESB事件流组件、应用程序服务器和自定义数据发布器)收集有关服务、中介者等的大量数据

实时分析数据

接收的任何数据事件流以进行实时和/或批量分析

● 使用sddhi实时分析

● 交互式分析

● Spark sql 批量分析

● 预测分析

决策

收集数据并对其进行各种分析以产生有意义的信息之后,使用多种呈现机制来呈现事件通知和处理结果。

● 分析仪表板

● 通知预警

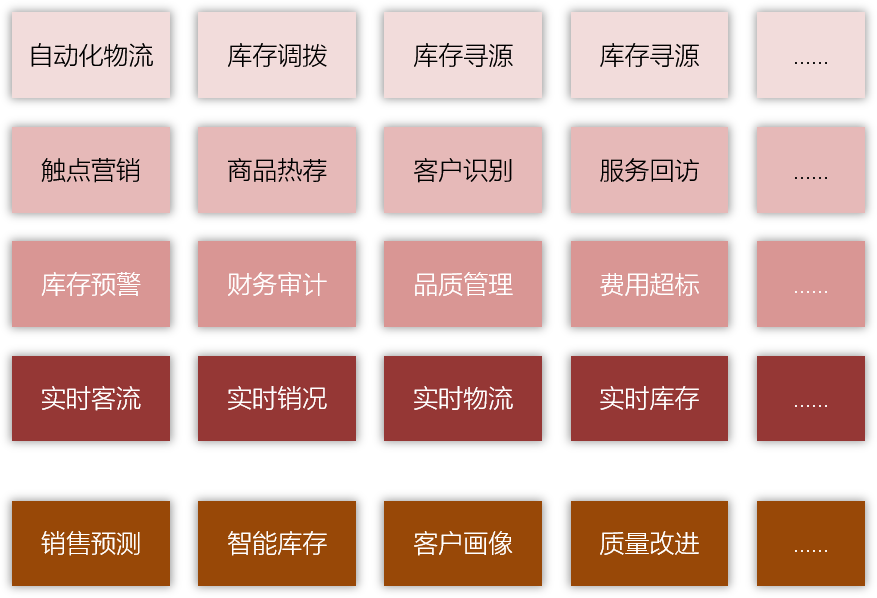

能力速览

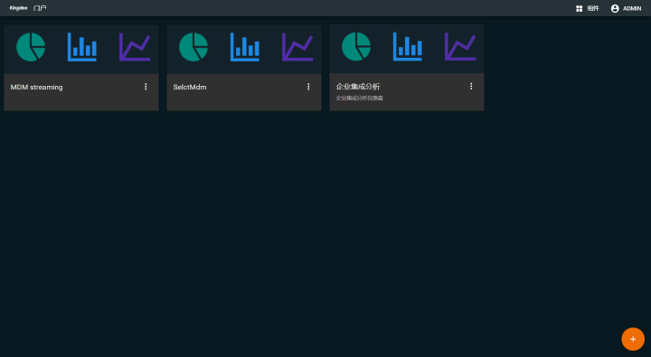

可视化事件流引擎

提供Web管理控制台,图形化的事件流查看、数据流向一览。

事件流接收、发布器管理

创建事件流配置,定义事件的元数据属性、相关属性及有效载荷属性的配置。查看系统中事件流配置。

实时数据分析

可定义定时执行的Spark SQL脚本,进行数据分析。

实时数据查询处理

提供SparkSQL控制台,可实时查询分析相关数据。